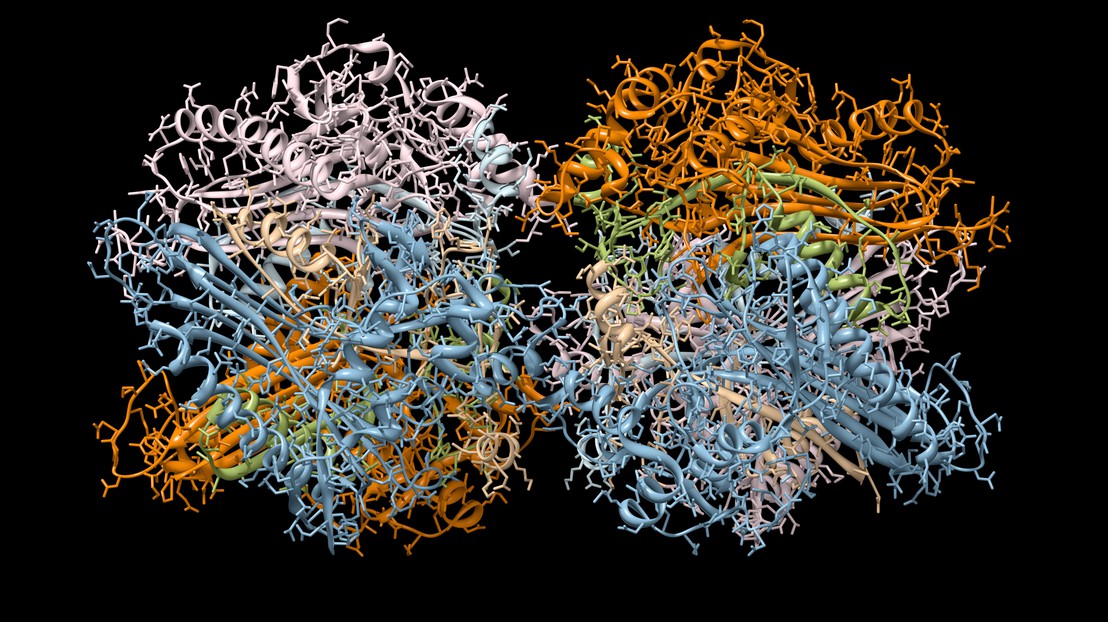

Un nouvel outil pour générer et concevoir des séquences de protéines

EPFL/ iStock

Des chercheuses et chercheurs de l’EPFL ont mis au point une nouvelle technique qui utilise un modèle de langage protéique pour générer des séquences de protéines ayant des propriétés comparables à celles des séquences naturelles. La méthode est plus performante que les modèles traditionnels et offre un potentiel prometteur pour la conception de protéines.

La conception de nouvelles protéines ayant une structure et une fonction spécifiques est un objectif très important de la bio-ingénierie, mais la taille considérable de l’espace des séquences de protéines complique la recherche de nouvelles protéines. Cependant, dans le cadre d’une récente étude, l’équipe d’Anne-Florence Bitbol de la Faculté des sciences de la vie de l’EPFL a découvert qu’un réseau neuronal d’apprentissage profond, MSA Transformer, pourrait être une solution prometteuse.

Développé en 2021, MSA Transformer fonctionne de manière similaire au traitement du langage naturel, utilisé par le désormais célèbre ChatGPT. Composée de Damiano Sgarbossa, d’Umberto Lupo et d’Anne-Florence Bitbol, l’équipe a proposé et testé une «méthode itérative», qui repose sur la capacité du modèle à prédire les parties manquantes ou masquées d’une séquence selon le contexte environnant.

L’équipe a découvert que, grâce à cette approche, MSA Transformer peut être utilisé pour générer de nouvelles séquences de protéines à partir de «familles» de protéines données (groupes de protéines ayant des séquences similaires), avec des propriétés similaires à celles des séquences naturelles.

En fait, les séquences de protéines générées à partir de grandes familles comportant de nombreux homologues présentent des propriétés meilleures ou similaires à celles des séquences générées par les modèles de Potts. «Un modèle de Potts est un type de modèle génératif complètement différent, qui n’est pas basé sur le traitement du langage naturel ou l’apprentissage profond et qui a été récemment validé expérimentalement», explique Anne-Florence Bitbol. «Notre nouvelle approche basée sur MSA Transformer nous a permis de générer des protéines même à partir de petites familles, où les modèles de Potts sont peu performants.»

MSA Transformer reproduit mieux les statistiques d’ordre supérieur et la distribution des séquences observées dans les données naturelles que les autres modèles, ce qui en fait un excellent candidat pour la génération de séquences de protéines et la conception de protéines.

«Ces travaux peuvent conduire au développement de nouvelles protéines ayant des structures et des fonctions spécifiques. On peut espérer que ces approches ouvriront la voie à d’importantes applications médicales à l’avenir», déclare Anne-Florence Bitbol. «Le potentiel de MSA Transformer en tant que candidat sérieux pour la conception de protéines offre de nouvelles possibilités passionnantes pour le domaine de la bio-ingénierie.»

Publiée dans le journal eLife, l’étude a été commentée comme suit par les éditrices et éditeurs: «Cette importante étude propose une méthode pour échantillonner de nouvelles séquences à partir d’un modèle de langage protéique qui pourrait avoir des applications passionnantes dans la conception de séquences de protéines. Ces affirmations sont étayées par une solide évaluation comparative des séquences conçues en termes de qualité, de nouveauté et de diversité.»

Conseil européen de la recherche (ERC) (Horizon 2020)

Damiano Sgarbossa, Umberto Lupo, Anne-Florence Bitbol. Generative power of a protein language model trained on multiple sequence alignments. eLife 03 February 2023. DOI: 10.7554/eLife.79854