Deux scientifiques d'IC ébauchent un plan pour une IA bénéfique

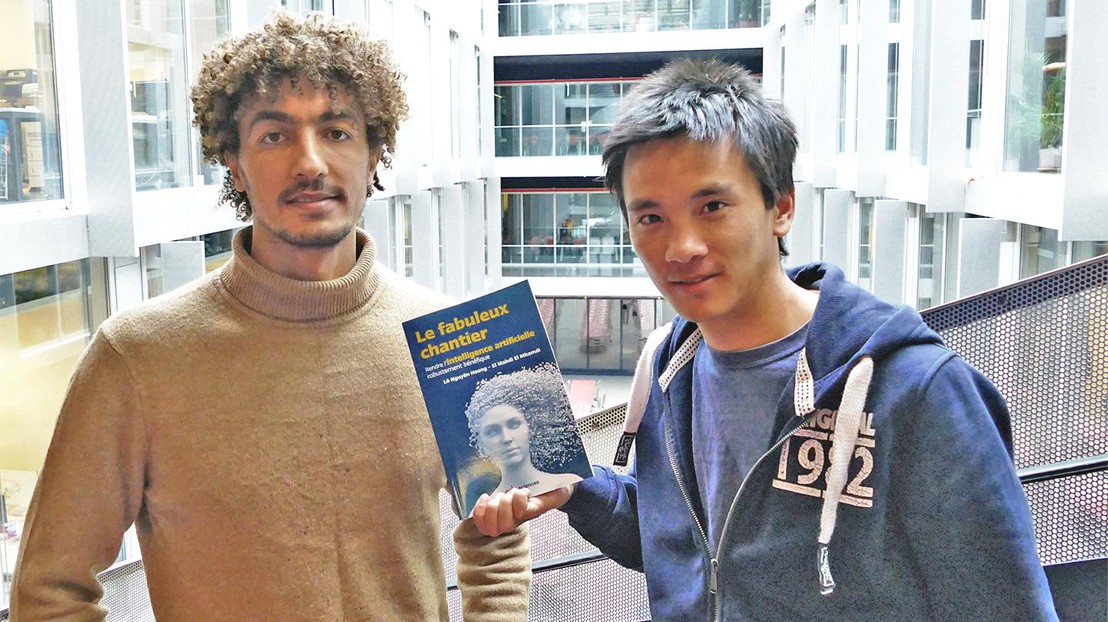

El Mahdi El Mhamdi et Lê Nguyên Hoang © 2019 IC EPFL

Les discussions sur les risques de l’intelligence artificielle (IA) portent souvent sur les technologies de demain (des robots doués de conscience ?) dysfonctionnant. Mais les chercheurs de la Faculté informatique et communications (IC) Lê Nguyên Hoang et El Mahdi El Mhamdi argumentent qu’il est important de se pencher sur les risques que représentent les algorithmes, qui influencent déjà notre quotidien – de la lecture de la presse aux vidéos sur YouTube.

Dans leur récent ouvrage « Le fabuleux chantier : rendre l’intelligence artificielle robustement bénéfique », Hoang et El Mhamdi appellent à reformuler les questions éthiques en termes computationnels – ce qui, selon eux, manquerait à la fois aux recherches en informatique et en éthique.

« De nombreuses questions éthiques en IA sont également techniques », explique El Mahdi El Mhamdi. « Mais on entend souvent dire qu’il s’agit de dilemmes qu’il appartient aux éthiciens de résoudre, alors que les éthiciens, de leur côté, vous diront qu’il appartient à l’informatique de les résoudre. »

« De la philosophie avec une échéance »

Dans leur livre, El Mahdi El Mhamdi et Lê Nguyên Hoang usent de leur expertise dans les systèmes de machine learning et dans les mathématiques afin de fournir une compréhension conceptuelle des algorithmes clé au grand public.

Un point sur lequel ils mettent une importance particulière est le besoin urgent d’une IA « robustement bénéfique », et ce non pas uniquement pour les technologies futures, mais également pour les algorithmes que l’on utilise déjà. Ils expliquent comment les limitations et vulnérabilités de ces algorithmes, qui sont largement sous-étudiées, peuvent résulter en des effets secondaires inattendus, menaçant sérieusement les activités humaines qu’ils impactent – de la communication au commerce en passant par le divertissement et la politique.

« Nous n’avons pas besoin de nous en référer à des IA exagérément improbables ou sophistiquées pour parler de l’urgence d’une sécurité pour l’IA », explique El Mahdi El Mhamdi. « Par exemple, les gens s’inquiètent d’une IA qui ne pourrait être arrêtée. Mais si l’on y regarde de plus près, il y a d’ores et déjà des millions de personnes qui ne peuvent éteindre leurs smartphones, parce que les algorithmes au sein des applications apprennent comment faire en sorte que l’utilisateur s’y attache. »

En l’absence de guidance éthique, les algorithmes font déjà des millions de très courtes décisions à propos de quels genres de contenus montrer et promouvoir, ce qui peut potentiellement mener à la diffusion des discours de haine, des fausses nouvelles, de propagande, de biais liés au genre ou encore d’autres problèmes. Citant le philosophe de l‘Université d’Oxford Nick Bostrom, Hoang et El Mhamdi se réfèrent à ce besoin urgent comme « de la philosophie avec une échéance ».

« Chaque jour qui passe sans un cadre éthique pour ces algorithmes est un jour de plus durant lequel les gens sont exposés à ce genre de contenus problématiques », déclare notamment Lê Nguyên Hoang.

Le problème de YouTube

L’un des exemples les plus frappants des auteurs est YouTube, qui compte chaque minute plus de vidéos vues que de recherches sur Google. YouTube utilise des algorithmes de recommandation pour sélectionner et afficher les vidéos aux utilisateurs. Conséquence directe, environ 70% des vidéos vues sur le service sont choisies par les utilisateurs via cette recommandation algorithmique, plutôt que via une recherche directe. Cela signifie que ces algorithmes ont une influence impressionnante sur ce que les gens voient, consomment et pensent.

« Les systèmes de recommandation ont des vulnérabilités, ce qui signifie que des hackers peuvent en prendre avantage pour permettre la diffusion massive de contenus indésirables, tels que les fausses nouvelles », prévient El Mahdi El Mhamdi.

Les auteurs discutent de comment rendre ces systèmes plus robustes et résistants à des échecs localisés, en mettant en avant des recommandations clé telles que la distribution et la décentralisation. Ils soulignent que parce qu’il est difficile de ré-agréger des données décentralisées efficacement et de manière sécurisée, ces défis créent des domaines de recherche fertiles pour les statisticiens, les scientifiques des données et les chercheurs en informatique.

Lê Nguyên Hoang ajoute que ce genre de questions pose les fondations pour un champ de recherches émergent particulièrement fertile pour les chercheurs en informatique en début de carrière, ainsi que pour ceux dans les domaines de la sociologie et de la psychologie.

« Aujourd’hui, beaucoup d’experts en informatique se concentrent sur la performance, ce qui est bien ; mais il se trouve que ces problématiques d’éthique computationnelle sont non-seulement plus urgents, mais aussi extrêmement stimulants et fascinants », déclare-t-il.

« Le fabuleux chantier : rendre l’intelligence artificielle robustement bénéfique » est d’ores et déjà disponible en français chez EDP Sciences. Une édition en anglais sera publiée en 2020. Voir une vidéo du vernissage du livre à l'EPFL le 28 novembre 2019.

El Mahdi El Mhamdi étudie la robustesse des réseaux biologiques et du machine learning distribué, et a récemment obtenu son PhD au sein du Laboratoire de calcul distribué (DCL) de Rachid Guerraoui. Lê Nguyên Hoang est un mathématicien et communicant en sciences. Il tient notamment la chaine YouTube ZettaBytes à propos de la recherche en IC, et est le créateur d’une populaire chaine de vulgarisation scientifique, Science4All. Il est également l’auteur d’un autre livre : « La formule du savoir : une philosophie unifiée du savoir fondée sur le théorème de Bayes »