Quand le «deep learning» confond une cafetière avec un cobra

Seyed Moosavi et Alhussein Fawzi© Alain Herzog/ 2017 EPFL

«S’agit-il de votre sœur ?» Les systèmes de reconnaissances d’images s’imposent dans les produits grand public, et sont envisagés pour la détection de tumeurs ou la génomique. Ils reposent sur des architectures appelées «deep learning», nouvelles stars de l’intelligence artificielle. A l’EPFL, des chercheurs mettent en lumière l’importante sensibilité de ces programmes. Une perturbation légère et universelle ajoutée à une image peut tromper complètement les meilleurs d’entre eux.

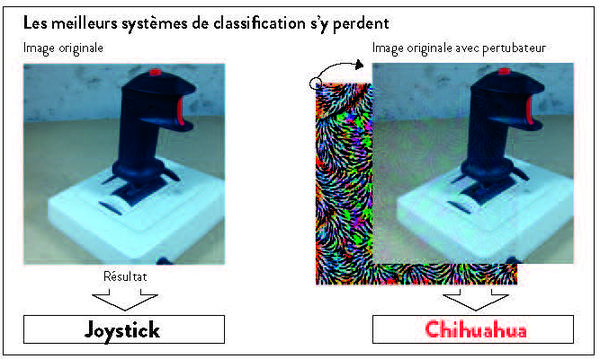

Véritable révolution pour l’analyse automatique d’images, les systèmes de «Deep learning» sont étonnamment très sensibles à des petites modifications de données. Des chercheurs du Laboratoire de traitement des signaux (LTS4), dirigé par Pascal Frossard, ont montré que l’on pouvait changer les résultats des meilleurs systèmes de classification basés sur ce genre d’architecture, en appliquant une perturbation à peine perceptible sur des images numériques. Face à cette perturbation, le système confond un joystick avec un chihuaha, et une cafetière devient un cobra. Le cerveau humain parvient quant à lui sans problème à reconnaître le contenu visuel correctement. Cette découverte sera présentée cet été lors de la conférence IEEE CVPR 2017, événement international majeur en matière de reconnaissance d’images. Elle permettra de mieux comprendre et d’améliorer ces systèmes, dont le potentiel est énorme. Rencontre avec Alhussein Fawzi et Seyed Moosavi, deux premiers auteurs de cette recherche.

Qu’est-ce que le «deep learning» et quel est le problème actuellement?

A.F: Les méthodes d’apprentissage et de classification «deep learning» ou «réseau de neurones artificiels» sont les nouvelles stars de l’intelligence artificielle. Toutes les grandes entreprises tech misent sur cette technologie pour faire de la reconnaissance d’objets, de visage, de texte ou de parole. On en retrouve différentes formes dans le moteur de recherche de Google, par exemple, ou chez Apple, avec SIRI. Ces méthodes donnent des résultats remarquables, à tel point qu’elles sont aussi envisagées pour la détection de tumeurs sur scanner, par exemple, ou pour faire marcher les voitures autonomes. Le seul problème, c’est que leur fonctionnement est opaque et souvent mal

compris. Peut-on leur faire confiance aveuglément? Est-ce une vraie surprise que l’on puisse tromper ces systèmes ?

Est-ce une vraie surprise que l’on puisse tromper ces systèmes ?

S.M : Il y a deux ans, des chercheurs ont déjà montré que les réseaux de neurones artificiels étaient peu robustes face à de petites perturbations spécifiquement conçues pour tromper la machine sur une image précise. Nous avons démontré que l’on pouvait en fait trouver une seule perturbation universelle qui permet de faire échouer le réseau de neurones sur la quasi-totalité des images. La perturbation est si légère qu’elle est quasiment invisible à l’œil nu. C’est surprenant et cela montre que ces systèmes ne sont pas si robustes qu’on pourrait le croire.

Comment le «deep learning» fonctionne-t-il ?

S.M : Il s’agit d’algorithmes d’apprentissage pour estimer l’information importante dans des ensembles de données. Tout part d’une machine virtuelle, soit un réseau de neurones artificiels, dont le rôle est de faire des calculs simples. Ces neurones sont disposés en plusieurs couches.

On présente à la machine un millier d’images de chats, par exemple, lui spécifiant que ce sont des chats. Dit grossièrement, la première couche de neurones analyse les caractéristiques de premier niveau, telles que les bords et les angles, la deuxième, les formes basiques, et ainsi de suite, jusqu’à deviner la forme toute entière, et identifier un chat. La machine s’entraine ainsi seule. Chaque couche se base sur les résultats de la couche précédente pour effectuer ses propres calculs. L’appellation «deep learning» vient de cet apprentissage hiérarchique en plusieurs couches.

A.F : Une fois entrainé, le système est capable de reconnaître des images de chats qu’il n’a encore jamais vues. Ces systèmes sont donc suffisamment «intelligents» pour effectuer la reconnaissance dans des situations inédites, et ne font pas uniquement un travail de mémorisation.

Comment avez-vous effectué votre analyse?

A.F : Nous avons calculé la perturbation la plus petite possible, qui permettait de faire capoter l’identification des images chez les meilleurs systèmes d’apprentissage. Lorsqu’elle est présente, le système se trompe pour la plupart des images naturelles. Dans les faits, il y a sur les images perturbées un changement léger de la valeur originale des pixels. Alors que l’œil humain ne voit que très peu de différences avec l’image originale, la machine, elle, est extrêmement affectée. Elle prend une chaussette pour un éléphant, et une plante verte pour un ara (réd. oiseau coloré). Ce qui est encore plus frappant, c’est que cette même perturbation permet de tromper plusieurs systèmes différents basés sur du «deep learning».

S.M : Reprenons l’exemple des chats. Un être humain, même un enfant de deux ans, aura développé et intégré le concept de chat après avoir vu cinq images de ces animaux, même en mélangeant des photos et des dessins. Cette capacité d’abstraction lui permet d’ignorer de petites perturbations, car celles-ci ne changent pas le concept présent sur une image. La machine, elle, n’est pas capable d’abstraction. Elle ne développe pas un concept, mais accumule plutôt une suite logique d’indices. C’est ce qui entraîne ses erreurs de classification.

Dans le monde réel, quel problème peut-on imaginer ?

S.M : Notre objectif est de mieux comprendre les systèmes de «deep learning», afin d’améliorer leur performance. Il y a actuellement un engouement pour le «deep learning» dans l’imagerie médicale, pour identifier certaines protéines, ou des tumeurs. Quand il s’agit de santé, il faut pouvoir compter sur des systèmes fiables. Il est donc primordial de bien comprendre les limitations des systèmes actuels, afin de les améliorer et de pouvoir fournir des garanties quant à leur performance.

Comme il a été assez simple de trouver la perturbation à appliquer, on peut imaginer que des personnes mal intentionnées pourraient potentiellement duper les machines assez facilement. Cela pourrait créer des problèmes dans les applications liées à la sécurité.

Quelle est l’étape suivante ?

S.M : Nous pensons qu’il devrait y avoir plus d’études théoriques autour du «deep learning». Nous proposons que les chercheurs se penchent plus profondément sur le fonctionnement des réseaux de neurones artificiels, sur leurs propriétés, leur potentiel énorme mais aussi les risques éventuels

Nous avons publié les codes de notre recherche. N’importe qui peut donc tester ces perturbations et étudier le problème. De notre côté, nous allons chercher à en savoir davantage sur le fonctionnement des architectures complexes de réseaux de neurones artificiels, afin de pouvoir améliorer leur robustesse.

Nous sommes déjà en relation avec des partenaires qui semblent intéressés par ces travaux de recherche.

-----

Publication dans arXiv: Universal adversarial perturbations